Il Vecchio Modo: Un Viaggio nella Memoria

Ricordi i bei vecchi tempi in cui aggiornare un servizio significava incrociare le dita e sperare per il meglio? Sì, in realtà non erano bei tempi. Ricapitoliamo il tradizionale processo di aggiornamento:

- Distribuire la nuova versione

- Attendere i controlli di integrità

- Spostare gradualmente il traffico

- Pregare gli dei del DevOps

- Eseguire il rollback se le cose vanno male

Questo approccio funzionava, ma era fluido quanto una strada sterrata. Entra in scena Kubernetes 1.32 e il suo spostamento proattivo dei carichi di lavoro.

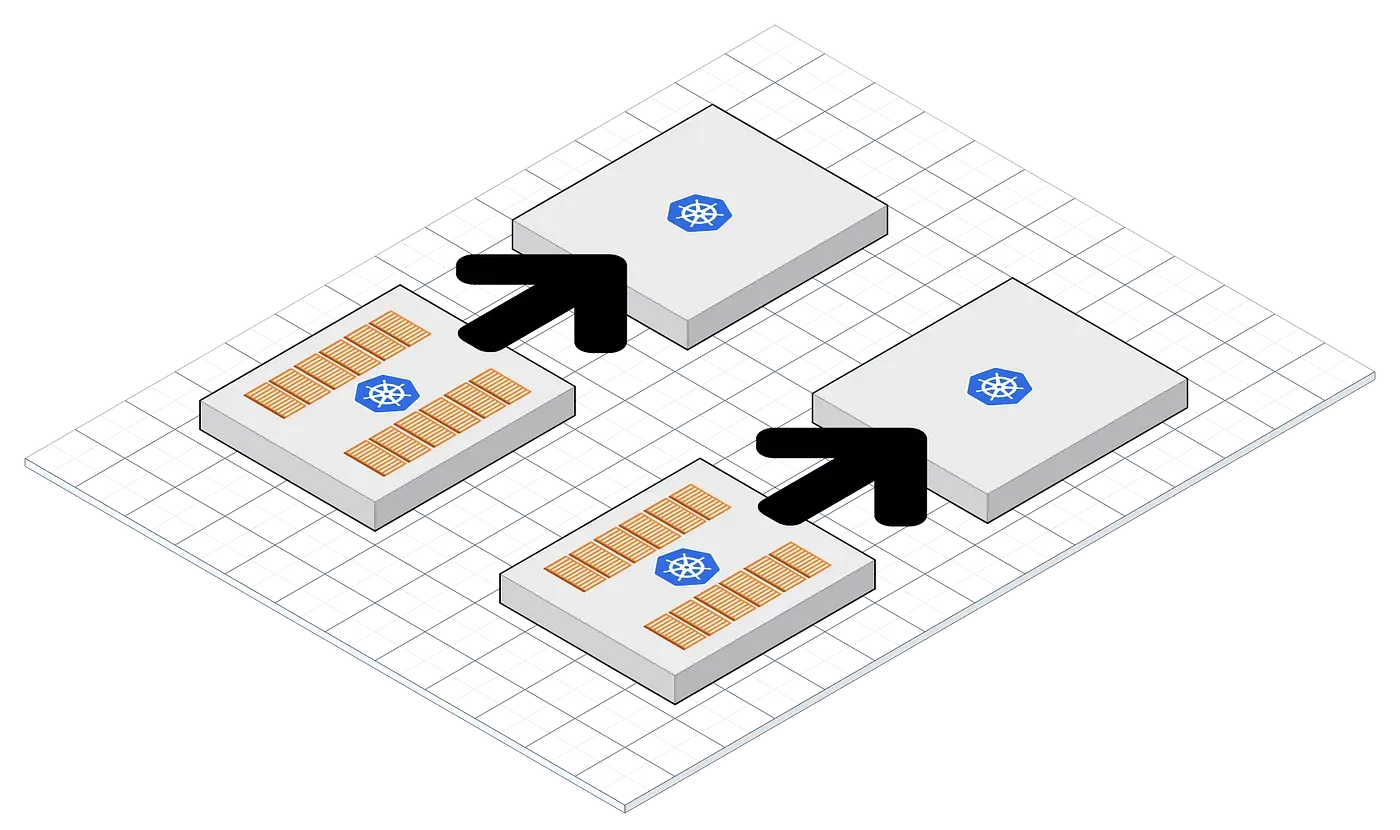

Spostamento Proattivo dei Carichi di Lavoro: La Nuova Tendenza

Quindi, cos'è esattamente questa funzione magica? In sostanza, è un modo per preparare il tuo cluster per un aggiornamento prima che avvenga. Ecco come funziona:

- Pre-riscaldare i nuovi pod

- Spostare gradualmente le richieste in arrivo

- Passare senza problemi alla nuova versione

- Terminare con grazia i vecchi pod

Analizziamolo, d'accordo?

1. Pre-riscaldamento dei Pod: Chi Prima Arriva, Meglio Alloggia

Kubernetes 1.32 ti permette di creare e inizializzare nuovi pod prima che siano necessari. Questo significa che la tua nuova versione è pronta all'uso in qualsiasi momento.

apiVersion: apps/v1

kind: Deployment

metadata:

name: my-app

spec:

replicas: 3

strategy:

type: RollingUpdate

rollingUpdate:

maxSurge: 1

maxUnavailable: 0

template:

metadata:

annotations:

k8s.v1.cni.cncf.io/networks: macvlan-conf

spec:

containers:

- name: my-app

image: my-app:v2

ports:

- containerPort: 8080

initContainers:

- name: init-myservice

image: busybox:1.28

command: ['sh', '-c', 'until nc -z myservice 80; do echo waiting for myservice; sleep 2; done;']

In questo esempio, stiamo usando un init container per assicurarci che le dipendenze del nostro servizio siano pronte prima che il container principale inizi.

2. Spostamento Graduale del Traffico: Chi Va Piano, Va Sano e Va Lontano

Una volta che i tuoi nuovi pod sono riscaldati, Kubernetes 1.32 può iniziare a spostare il traffico verso di essi gradualmente. Qui avviene la magia:

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: my-ingress

annotations:

kubernetes.io/ingress.class: nginx

nginx.ingress.kubernetes.io/canary: "true"

nginx.ingress.kubernetes.io/canary-weight: "10"

spec:

rules:

- host: myapp.example.com

http:

paths:

- path: /

pathType: Prefix

backend:

service:

name: my-app-v2

port:

number: 80

Questa configurazione Ingress dice a Kubernetes di inviare il 10% del traffico alla nuova versione. Puoi aumentare gradualmente questa percentuale man mano che acquisisci fiducia nella nuova versione.

3. Transizione Senza Soluzione di Continuità: Come un Boss

Quando la nuova versione si dimostra stabile, puoi aumentare lo spostamento del traffico fino a quando tutte le richieste vengono gestite dai nuovi pod. La parte migliore? I tuoi utenti non se ne accorgeranno nemmeno.

4. Terminazione con Grazia: Nessun Pod Lasciato Indietro

Infine, Kubernetes 1.32 garantisce che i vecchi pod vengano terminati con grazia, permettendo loro di completare l'elaborazione di eventuali richieste in corso prima di spegnersi.

apiVersion: policy/v1

kind: PodDisruptionBudget

metadata:

name: my-app-pdb

spec:

maxUnavailable: 1

selector:

matchLabels:

app: my-app

Questo PodDisruptionBudget assicura che al massimo un pod sia non disponibile durante il processo di aggiornamento, mantenendo la disponibilità del servizio.

Ma Aspetta, C'è di Più!

Lo spostamento proattivo dei carichi di lavoro di Kubernetes 1.32 non riguarda solo aggiornamenti fluidi. Porta anche alcuni vantaggi aggiuntivi:

- Efficienza delle Risorse: Pre-riscaldando i pod, puoi assicurarti che le risorse siano disponibili quando ne hai bisogno, senza sovra-allocare.

- Affidabilità Migliorata: Lo spostamento graduale del traffico significa che puoi individuare i problemi in anticipo, prima che influenzino tutti gli utenti.

- Miglior Test: Puoi eseguire test A/B o rilasci canary con facilità, raccogliendo dati reali sulle prestazioni della tua nuova versione.

Trappole e Insidie: Non è Tutto Sole e Arcobaleni

Prima di immergerti completamente nello spostamento proattivo dei carichi di lavoro, ci sono alcune cose da tenere a mente:

- Consumo di Risorse: Pre-riscaldare i pod significa che avrai bisogno di risorse extra durante il processo di aggiornamento. Assicurati che il tuo cluster possa gestirlo.

- Complessità della Configurazione: Configurare lo spostamento proattivo dei carichi di lavoro richiede una configurazione attenta. Testa accuratamente in ambienti non di produzione prima.

- Applicazioni Stateful: Mentre questo funziona alla grande per i microservizi stateless, le applicazioni stateful potrebbero richiedere considerazioni aggiuntive.

"Con grande potere viene grande responsabilità." - Zio Ben (e ogni ingegnere DevOps di sempre)

Mettere Tutto Insieme: Un Esempio Reale

Supponiamo che tu stia aggiornando un servizio critico di elaborazione dei pagamenti. Ecco come potresti utilizzare lo spostamento proattivo dei carichi di lavoro:

- Distribuire la nuova versione con zero repliche

- Scalare gradualmente la nuova versione mantenendo in esecuzione quella vecchia

- Utilizzare le regole Ingress per spostare una piccola percentuale di traffico verso la nuova versione

- Monitorare errori e problemi di prestazioni

- Aumentare gradualmente il traffico verso la nuova versione

- Una volta che il 100% del traffico è sulla nuova versione, ridurre e rimuovere la vecchia versione

Ecco un frammento di come potrebbe apparire la tua distribuzione:

apiVersion: apps/v1

kind: Deployment

metadata:

name: payment-service-v2

spec:

replicas: 0 # Inizia con zero repliche

selector:

matchLabels:

app: payment-service

version: v2

template:

metadata:

labels:

app: payment-service

version: v2

spec:

containers:

- name: payment-service

image: payment-service:v2

ports:

- containerPort: 8080

readinessProbe:

httpGet:

path: /health

port: 8080

initialDelaySeconds: 10

periodSeconds: 5

resources:

requests:

cpu: 100m

memory: 128Mi

limits:

cpu: 500m

memory: 512Mi

Utilizzeresti quindi l'Horizontal Pod Autoscaler (HPA) per aumentare gradualmente il numero di repliche basandoti su metriche come l'utilizzo della CPU o metriche personalizzate.

Il Futuro è Adesso: Abbracciare lo Spostamento Proattivo dei Carichi di Lavoro

Lo spostamento proattivo dei carichi di lavoro di Kubernetes 1.32 è un punto di svolta per chiunque cerchi di ottenere veri aggiornamenti senza interruzioni. Sfruttando questa funzione, puoi:

- Minimizzare i rischi durante gli aggiornamenti

- Migliorare l'esperienza utente eliminando i tempi di inattività

- Acquisire maggiore fiducia nel tuo processo di distribuzione

- Dormire meglio la notte (i risultati possono variare)

Allora, sei pronto a portare le tue distribuzioni Kubernetes al livello successivo? Immergiti, sperimenta lo spostamento proattivo dei carichi di lavoro e dì addio all'ansia da aggiornamento una volta per tutte!

Spunti di Riflessione

Mentre implementi lo spostamento proattivo dei carichi di lavoro nei tuoi cluster, considera le seguenti domande:

- Come puoi integrare questo approccio con le tue pipeline CI/CD esistenti?

- Quali metriche dovresti monitorare per garantire una transizione di successo?

- Come potrebbe evolversi questa funzione nelle future versioni di Kubernetes?

Ricorda, il mondo di Kubernetes è in continua evoluzione. Rimani curioso, continua a sperimentare e non smettere mai di imparare. Buon spostamento!