La precisione è fondamentale nell'apprendimento automatico. Molto. È la differenza tra il tuo AI che riconosce un gatto e pensa di vedere un tostapane. Ma ecco il punto - a volte, più precisione non è sempre meglio. Entra in scena l'arrotondamento stocastico.

Arrotondamento Stocastico 101

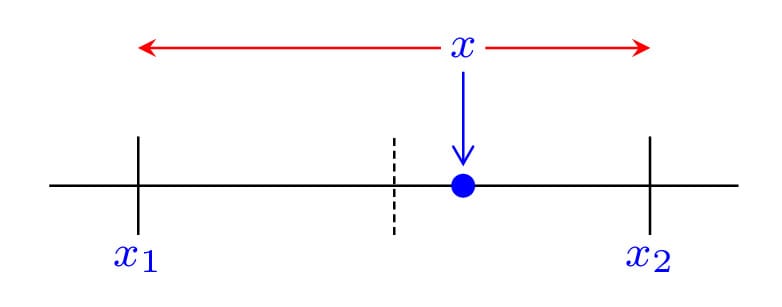

Quindi, cos'è esattamente questa tecnica magica? In termini semplici, l'arrotondamento stocastico è un metodo di arrotondamento dei numeri che introduce un po' di casualità nel processo. Invece di arrotondare sempre al valore più vicino, a volte arrotonda verso l'alto o verso il basso in base alla probabilità.

Ecco un esempio veloce:

import random

def stochastic_round(x):

floor = int(x)

return floor + (random.random() < (x - floor))

# Esempio di utilizzo

print(stochastic_round(3.7)) # Potrebbe essere 3 o 4

print(stochastic_round(3.7)) # Potrebbe essere 3 o 4

print(stochastic_round(3.7)) # Potrebbe essere 3 o 4

Esegui questo codice alcune volte e vedrai che 3.7 non si arrotonda sempre a 4. A volte è 3, a volte è 4. È come l'arrotondamento di Schrödinger - sia verso l'alto che verso il basso finché non lo osservi!

Perché Dovremmo Interessarci?

Ora, potresti pensare, "Fantastico, abbiamo introdotto la casualità. Come ci aiuta?" Bene, mio amico scettico, lascia che ti elenchi i modi:

- Riduzione del Bias: L'arrotondamento tradizionale può introdurre un bias sistematico, specialmente quando si lavora con molti valori piccoli. L'arrotondamento stocastico aiuta a mitigare questo problema.

- Migliori Stime del Gradiente: Nell'apprendimento profondo, l'arrotondamento stocastico può portare a stime del gradiente più accurate durante la retropropagazione.

- Miglior Convergenza: Alcuni studi hanno dimostrato che l'arrotondamento stocastico può aiutare le reti neurali a convergere più velocemente e a migliori ottimi.

- Efficienza Hardware: Permette l'uso di hardware a bassa precisione mantenendo risultati ad alta precisione.

Impatto nel Mondo Reale

Ancora non convinto? Diamo un'occhiata ad alcuni esempi concreti dove l'arrotondamento stocastico sta facendo scalpore:

1. Addestramento a Bassa Precisione

Ricercatori di Facebook AI Research (ora Meta AI) hanno scoperto che l'uso dell'arrotondamento stocastico ha permesso loro di addestrare grandi modelli di linguaggio a una precisione di 8 bit senza perdita di accuratezza. Questo è enorme per ridurre l'uso della memoria e i requisiti computazionali.

2. Quantizzazione Migliorata

Il TPU (Tensor Processing Unit) di Google utilizza l'arrotondamento stocastico nel suo formato bfloat16, permettendo un addestramento e un'inferenza più veloci senza sacrificare la qualità del modello.

3. Calcolo Scientifico

Al di fuori del ML, l'arrotondamento stocastico viene utilizzato nei modelli climatici e nelle simulazioni di dinamica dei fluidi per mantenere l'accuratezza utilizzando aritmetica a bassa precisione.

Il Lato Oscuro dell'Arrotondamento Stocastico

Ora, prima di correre a implementare l'arrotondamento stocastico ovunque, parliamo di alcuni potenziali problemi:

- Riproducibilità: La casualità nell'arrotondamento stocastico può rendere difficile la riproducibilità esatta dei risultati.

- Sovraccarico: Generare numeri casuali per l'arrotondamento può introdurre un sovraccarico computazionale.

- Non Sempre Vantaggioso: In alcuni casi, specialmente con reti molto profonde, i benefici potrebbero essere meno evidenti.

"Con grande potere viene grande responsabilità" - Zio Ben (e ogni data scientist che usa l'arrotondamento stocastico)

Implementazione dell'Arrotondamento Stocastico

Sei entusiasta di provarlo? Ecco un'implementazione Python più completa con cui puoi giocare:

import numpy as np

def stochastic_round(x, precision=1):

scale = 10 ** precision

scaled = x * scale

floor = np.floor(scaled)

prob = scaled - floor

rounded = floor + (np.random.random(x.shape) < prob)

return rounded / scale

# Esempio di utilizzo

x = np.array([1.34, 2.67, 3.45, 4.82])

print("Originale:", x)

print("Arrotondato stocasticamente:", stochastic_round(x))

print("Arrotondamento Numpy:", np.round(x))

Esegui questo codice alcune volte e confronta i risultati. Vedrai che l'arrotondamento stocastico a volte dà risultati diversi, mentre l'arrotondamento di numpy è sempre coerente.

Il Futuro della Precisione

Man mano che i modelli di apprendimento automatico diventano più grandi e complessi, tecniche come l'arrotondamento stocastico diventeranno sempre più importanti. Stiamo già vedendo produttori di hardware come NVIDIA incorporare il supporto per l'arrotondamento stocastico nei loro ultimi GPU.

Quindi, cosa ci aspetta? Alcune aree da tenere d'occhio:

- Addestramento a Precisione Ibrida: Combinare diverse precisioni e metodi di arrotondamento per diversi strati o operazioni.

- Arrotondamento Stocastico Adattivo: Regolare dinamicamente il comportamento di arrotondamento in base allo stato attuale dell'addestramento.

- Accelerazione Hardware: Maggiore supporto hardware dedicato per operazioni di arrotondamento stocastico efficienti.

Conclusione

L'arrotondamento stocastico potrebbe sembrare un piccolo dettaglio nel grande schema dell'apprendimento automatico, ma sono queste innovazioni che spingono il campo in avanti. Ci permette di addestrare modelli più grandi in modo più efficiente, eseguire simulazioni con maggiore accuratezza e spingere i limiti di ciò che è possibile con risorse hardware limitate.

Quindi, la prossima volta che qualcuno ti chiede delle ultime novità nel ML, non parlare solo di trasformatori o apprendimento per rinforzo. Condividi qualche conoscenza sull'arrotondamento stocastico e guarda i loro occhi illuminarsi di eccitazione!

Spunti di Riflessione

Prima di andare, ecco alcune domande su cui riflettere:

- Come potrebbe l'arrotondamento stocastico influenzare l'interpretabilità del modello?

- Le tecniche di arrotondamento stocastico potrebbero essere utilizzate per migliorare la privacy negli scenari di apprendimento federato?

- Quali altre aree dell'informatica o dell'ingegneria potrebbero beneficiare dell'arrotondamento stocastico?

Ricorda, nel mondo dell'apprendimento automatico, a volte un po' di casualità può portare a molta precisione. Ora vai e arrotonda stocasticamente!