Perché scegliere soluzioni personalizzate quando ci sono soluzioni pronte all'uso?

- Flessibilità: Adatta i limiti ai tuoi casi d'uso specifici e ai livelli degli utenti

- Prestazioni: Ottimizza per la tua infrastruttura e i modelli di traffico

- Controllo: Affina ogni aspetto di come gestisci il consumo delle API

- Apprendimento: Ottieni approfondimenti più profondi sul comportamento e sui modelli di utilizzo della tua API

Ora che siamo sulla stessa lunghezza d'onda, entriamo nei dettagli!

I Fondamenti: Algoritmi di Limitazione del Tasso

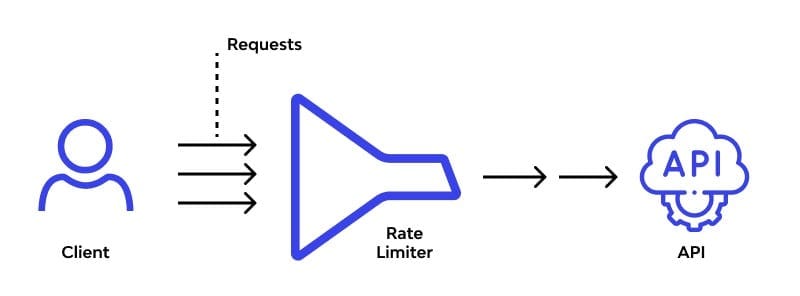

Al cuore di qualsiasi soluzione di limitazione del tasso ci sono gli algoritmi. Esploriamo alcuni dei più popolari e vediamo come possiamo implementarli:

1. Algoritmo del Secchio di Token

Immagina un secchio che si riempie di token a un ritmo costante. Ogni richiesta API consuma un token. Se il secchio è vuoto, la richiesta viene negata. Semplice, ma efficace!

import time

class TokenBucket:

def __init__(self, capacity, fill_rate):

self.capacity = capacity

self.fill_rate = fill_rate

self.tokens = capacity

self.last_fill = time.time()

def consume(self, tokens):

now = time.time()

time_passed = now - self.last_fill

self.tokens = min(self.capacity, self.tokens + time_passed * self.fill_rate)

self.last_fill = now

if self.tokens >= tokens:

self.tokens -= tokens

return True

return False

# Uso

bucket = TokenBucket(capacity=100, fill_rate=10) # 100 token, ricarica 10 al secondo

if bucket.consume(1):

print("Richiesta consentita")

else:

print("Limite di tasso superato")

2. Algoritmo del Secchio Perforato

Pensa a un secchio con un piccolo foro sul fondo. Le richieste riempiono il secchio, e "perdono" a un ritmo costante. Se il secchio trabocca, le richieste in arrivo vengono scartate.

from collections import deque

import time

class LeakyBucket:

def __init__(self, capacity, leak_rate):

self.capacity = capacity

self.leak_rate = leak_rate

self.bucket = deque()

self.last_leak = time.time()

def add(self):

now = time.time()

self._leak(now)

if len(self.bucket) < self.capacity:

self.bucket.append(now)

return True

return False

def _leak(self, now):

leak_time = (now - self.last_leak) * self.leak_rate

while self.bucket and self.bucket[0] <= now - leak_time:

self.bucket.popleft()

self.last_leak = now

# Uso

bucket = LeakyBucket(capacity=5, leak_rate=0.5) # 5 richieste, perde 1 ogni 2 secondi

if bucket.add():

print("Richiesta consentita")

else:

print("Limite di tasso superato")

3. Contatore a Finestra Fissa

Questo è semplice: dividi il tempo in finestre fisse e conta le richieste in ciascuna. Resetta il contatore quando inizia una nuova finestra.

import time

class FixedWindowCounter:

def __init__(self, window_size, max_requests):

self.window_size = window_size

self.max_requests = max_requests

self.current_window = time.time() // window_size

self.request_count = 0

def allow_request(self):

current_time = time.time()

window = current_time // self.window_size

if window > self.current_window:

self.current_window = window

self.request_count = 0

if self.request_count < self.max_requests:

self.request_count += 1

return True

return False

# Uso

counter = FixedWindowCounter(window_size=60, max_requests=100) # 100 richieste al minuto

if counter.allow_request():

print("Richiesta consentita")

else:

print("Limite di tasso superato")

Implementazione in un API Gateway

Ora che abbiamo i nostri algoritmi, vediamo come possiamo integrarli in un API gateway. Useremo FastAPI per questo esempio, ma il concetto si applica anche ad altri framework.

from fastapi import FastAPI, Request, HTTPException

from fastapi.middleware.cors import CORSMiddleware

from TokenBucket import TokenBucket

app = FastAPI()

# Aggiungi middleware CORS

app.add_middleware(

CORSMiddleware,

allow_origins=["*"],

allow_credentials=True,

allow_methods=["*"],

allow_headers=["*"],

)

# Crea un limitatore di tasso per ogni client

rate_limiters = {}

@app.middleware("http")

async def rate_limit_middleware(request: Request, call_next):

client_ip = request.client.host

if client_ip not in rate_limiters:

rate_limiters[client_ip] = TokenBucket(capacity=100, fill_rate=10)

if not rate_limiters[client_ip].consume(1):

raise HTTPException(status_code=429, detail="Limite di tasso superato")

response = await call_next(request)

return response

@app.get("/")

async def root():

return {"message": "Ciao, mondo con limitazione del tasso!"}

Questa configurazione crea un limitatore di tasso separato per ogni IP del client, consentendo 100 richieste con un tasso di ricarica di 10 token al secondo.

Tecniche Avanzate e Considerazioni

Mentre implementi la tua soluzione personalizzata di limitazione del tasso, tieni a mente questi punti:

1. Limitazione del Tasso Distribuita

Quando la tua API funziona su più server, avrai bisogno di un modo per sincronizzare i dati di limitazione del tasso. Considera l'uso di una cache distribuita come Redis:

import redis

class DistributedRateLimiter:

def __init__(self, redis_url, key_prefix, limit, window):

self.redis = redis.from_url(redis_url)

self.key_prefix = key_prefix

self.limit = limit

self.window = window

def is_allowed(self, identifier):

key = f"{self.key_prefix}:{identifier}"

current = self.redis.get(key)

if current is None:

self.redis.set(key, 1, ex=self.window)

return True

elif int(current) < self.limit:

self.redis.incr(key)

return True

return False

# Uso

limiter = DistributedRateLimiter("redis://localhost", "api_limit", 100, 60)

if limiter.is_allowed("user123"):

print("Richiesta consentita")

else:

print("Limite di tasso superato")

2. Limitazione del Tasso Dinamica

Adatta i tuoi limiti di tasso in base al carico del server o ad altre metriche. Questo può aiutare a prevenire sovraccarichi durante i picchi di traffico:

import psutil

def get_dynamic_rate_limit():

cpu_usage = psutil.cpu_percent()

if cpu_usage > 80:

return 50 # Riduci il limite di tasso quando la CPU è sotto carico pesante

elif cpu_usage > 60:

return 75

else:

return 100

# Usa questo nella tua logica di limitazione del tasso

dynamic_limit = get_dynamic_rate_limit()

3. Limiti di Tasso Specifici per Utente

Implementa diversi limiti di tasso per vari livelli di utenti o chiavi API:

def get_user_rate_limit(api_key):

user_tier = database.get_user_tier(api_key)

if user_tier == "premium":

return 1000

elif user_tier == "standard":

return 100

else:

return 10

# Usa questo quando inizializzi i limitatori di tasso

user_limit = get_user_rate_limit(api_key)

rate_limiter = TokenBucket(capacity=user_limit, fill_rate=user_limit/60)

Monitoraggio e Analisi

Non dimenticare di implementare il monitoraggio per il tuo sistema di limitazione del tasso. Questo ti aiuterà a perfezionare i tuoi algoritmi e a individuare eventuali problemi in anticipo.

- Registra i colpi di limite di tasso e i quasi mancati

- Traccia i modelli di utilizzo delle API

- Imposta avvisi per picchi o cali insoliti nel traffico

Considera l'uso di strumenti come Prometheus e Grafana per visualizzare le metriche di limitazione del tasso:

from prometheus_client import Counter, Histogram

REQUESTS = Counter('api_requests_total', 'Total API requests')

RATE_LIMIT_HITS = Counter('rate_limit_hits_total', 'Total rate limit hits')

LATENCY = Histogram('request_latency_seconds', 'Request latency in seconds')

@app.middleware("http")

async def metrics_middleware(request: Request, call_next):

REQUESTS.inc()

with LATENCY.time():

response = await call_next(request)

if response.status_code == 429:

RATE_LIMIT_HITS.inc()

return response

Conclusione: Padroneggiare l'Arte del Controllo del Traffico API

Implementare algoritmi di limitazione del tasso personalizzati è come dirigere una sinfonia di richieste API. Richiede finezza, regolazione costante e una profonda comprensione del ritmo unico della tua API. Ma con l'approccio giusto, puoi creare un equilibrio armonioso tra la protezione delle tue risorse e la fornitura di una grande esperienza per i tuoi utenti.

Ricorda, la soluzione perfetta di limitazione del tasso è quella che evolve con la tua API. Non aver paura di sperimentare, raccogliere dati e perfezionare i tuoi algoritmi nel tempo. Il tuo futuro te stesso (e i tuoi server) ti ringrazieranno!

"L'arte della limitazione del tasso non riguarda il dire 'no', ma il dire 'non adesso' nel modo più elegante possibile." - Anonimo Guru delle API

Ora vai avanti e doma quel mostro del traffico API! E se hai già combattuto questa bestia, condividi le tue storie di guerra nei commenti. Dopotutto, le migliori strategie di limitazione del tasso sono forgiate nel fuoco dell'esperienza reale.