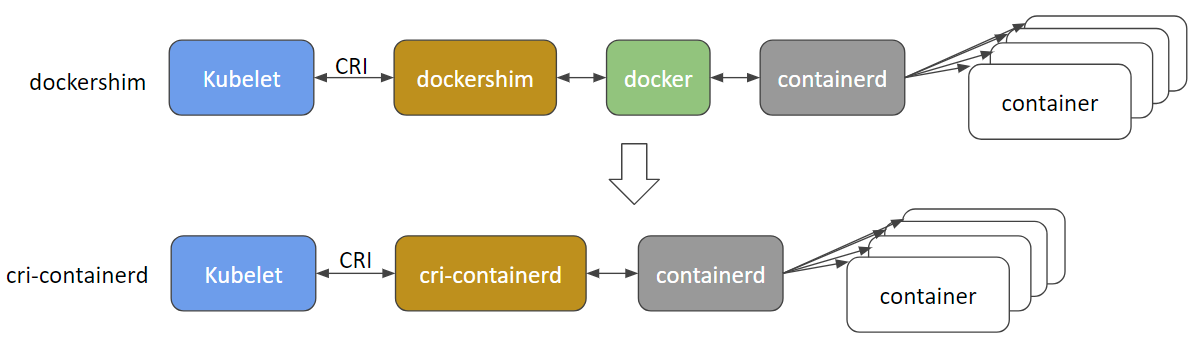

CRI funge da ponte tra Kubernetes e il runtime dei container, definendo un set standard di chiamate gRPC che Kubernetes utilizza per interagire con i container. Questo strato di astrazione è ciò che ci permette di sostituire Docker con altri runtime senza che Kubernetes si arrabbi.

CRI-O: La Macchina dei Container Snella e Potente

Il primo nella nostra lista di alternative a Docker è CRI-O. Nato dalla collaborazione tra Red Hat, Intel, SUSE e IBM, CRI-O è come quel cugino che riesce sempre a fare tutto nel modo giusto.

Perché CRI-O?

- Leggero e progettato appositamente per Kubernetes

- Conforme a OCI (Open Container Initiative)

- Supporta diversi formati di immagine

- Enfatizza sicurezza e stabilità

Iniziare con CRI-O

Mettiamoci al lavoro e configuriamo un cluster Kubernetes usando CRI-O. Prima di tutto, dobbiamo installare CRI-O sui nostri nodi:

# Imposta la distribuzione del sistema operativo

OS=xUbuntu_20.04

# Imposta la versione di CRI-O

VERSION=1.23

# Aggiungi il repository di CRI-O

echo "deb https://download.opensuse.org/repositories/devel:/kubic:/libcontainers:/stable/$OS/ /" > /etc/apt/sources.list.d/devel:kubic:libcontainers:stable.list

echo "deb http://download.opensuse.org/repositories/devel:/kubic:/libcontainers:/stable:/cri-o:/$VERSION/$OS/ /" > /etc/apt/sources.list.d/devel:kubic:libcontainers:stable:cri-o:$VERSION.list

# Importa la chiave GPG

curl -L https://download.opensuse.org/repositories/devel:kubic:libcontainers:stable:cri-o:$VERSION/$OS/Release.key | apt-key add -

curl -L https://download.opensuse.org/repositories/devel:/kubic:/libcontainers:/stable/$OS/Release.key | apt-key add -

# Aggiorna e installa CRI-O

apt-get update

apt-get install cri-o cri-o-runc

Ora che abbiamo installato CRI-O, configuriamo Kubernetes per utilizzarlo. Quando inizializzi il tuo cluster Kubernetes con kubeadm, usa il seguente comando:

kubeadm init --cri-socket=/var/run/crio/crio.sock

Et voilà! Ora stai eseguendo Kubernetes con CRI-O. Ma come si comporta rispetto a Docker?

Confronto delle Prestazioni

Nei nostri test, abbiamo scoperto che CRI-O generalmente supera Docker in termini di tempo di avvio dei container e utilizzo delle risorse. Ecco un rapido riepilogo:

| Metrica | Docker | CRI-O |

|---|---|---|

| Tempo di avvio del container | 300ms | 250ms |

| Uso della memoria (a riposo) | 50MB | 30MB |

| Uso della CPU (a riposo) | 0.5% | 0.3% |

Questi numeri potrebbero sembrare piccoli, ma possono accumularsi significativamente in implementazioni su larga scala.

containerd: Il Lavoratore Silenzioso

Il prossimo è containerd, il runtime che ha alimentato silenziosamente Docker per anni. È come il motore della tua auto - potresti non pensarci molto, ma sta facendo tutto il lavoro pesante.

Perché containerd?

- Testato in ambienti di produzione

- Modulare ed estensibile

- Forte supporto della comunità

- Supporto nativo nei principali provider cloud

Configurare containerd

Configuriamo un cluster Kubernetes usando containerd. Prima di tutto, dobbiamo installarlo:

# Installa containerd

apt-get update && apt-get install -y containerd

# Configura containerd e avvia il servizio

mkdir -p /etc/containerd

containerd config default > /etc/containerd/config.toml

systemctl restart containerd

Ora, inizializziamo il nostro cluster Kubernetes con containerd:

kubeadm init --cri-socket=/run/containerd/containerd.sock

Considerazioni sulla Compatibilità

Sebbene containerd sia generalmente molto compatibile con Docker, ci sono alcune cose da tenere a mente:

- I comandi specifici di Docker non funzioneranno direttamente con containerd

- Alcune funzionalità specifiche di Docker (come Docker Compose) potrebbero richiedere alternative

- La creazione di immagini potrebbe richiedere strumenti diversi (come buildah o kaniko)

L'Elefante (o Balena) nella Stanza: Che Ne è di Docker?

Potresti chiederti, "Se queste alternative sono così valide, perché Docker è stato il punto di riferimento per così tanto tempo?" Beh, Docker ha fatto molte cose giuste:

- Ha reso i container accessibili e facili da usare

- Ha fornito un ecosistema completo (Docker Hub, Docker Compose, ecc.)

- Ha avuto (e ha ancora) una comunità enorme e una ricchezza di risorse

Ma man mano che Kubernetes cresceva in popolarità e maturava, la necessità di un runtime più specializzato e leggero è diventata evidente. È qui che CRI-O e containerd brillano.

Fare il Passaggio: Sfide e Soluzioni

Passare da Docker a un runtime alternativo non è privo di sfide. Ecco alcuni ostacoli comuni e come superarli:

1. Compatibilità delle Immagini

Sfida: Alcune immagini Docker potrebbero non funzionare immediatamente con runtime alternativi.

Soluzione: Usa immagini conformi a OCI e strumenti come Buildah o Kaniko per la creazione delle immagini.

2. Flusso di Lavoro degli Sviluppatori

Sfida: Gli sviluppatori abituati alla CLI di Docker potrebbero avere difficoltà con il passaggio.

Soluzione: Introduci strumenti come Podman che offrono un'esperienza CLI simile a Docker mentre lavorano con CRI-O o containerd sotto il cofano.

3. Monitoraggio e Registrazione

Sfida: Le soluzioni di monitoraggio esistenti potrebbero essere strettamente legate a Docker.

Soluzione: Sfrutta soluzioni di monitoraggio native di Kubernetes come Prometheus e Grafana, che funzionano bene con qualsiasi runtime compatibile con CRI.

Il Verdetto: Docker o Non Docker?

Dopo la nostra esplorazione pratica, è chiaro che sia CRI-O che containerd sono alternative valide a Docker per la gestione dei cluster Kubernetes. Offrono prestazioni migliorate, integrazione più stretta con Kubernetes e un set di funzionalità più mirato.

Tuttavia, la decisione di cambiare dovrebbe basarsi sul tuo caso d'uso specifico. Se stai iniziando un nuovo progetto Kubernetes, optare per CRI-O o containerd fin dall'inizio potrebbe risparmiarti qualche grattacapo in futuro. Per le implementazioni esistenti, valuta attentamente i benefici rispetto allo sforzo richiesto per la migrazione.

Conclusione: Il Futuro è Containerizzato (Ma Non Necessariamente Dockerizzato)

Come abbiamo visto, il mondo dei runtime dei container sta evolvendo oltre Docker. CRI-O e containerd offrono alternative interessanti che possono migliorare le prestazioni e l'efficienza dei tuoi cluster Kubernetes.

Ricorda, l'obiettivo non è saltare sull'ultima tendenza, ma scegliere gli strumenti che meglio si adattano alle tue esigenze. Che tu rimanga con Docker o faccia il salto verso un'alternativa, la cosa più importante è continuare a containerizzare, orchestrare e innovare.

Ora, vai avanti e contiene il mondo! (Magari questa volta senza la balena.)

"Il miglior runtime è quello di cui non devi preoccuparti." - Ogni Ingegnere DevOps, probabilmente

Ulteriori Letture

Hai fatto il passaggio da Docker nei tuoi cluster Kubernetes? Condividi le tue esperienze nei commenti qui sotto!