Nei tempi antichi (tipo, martedì scorso), avremmo creato thread o processi per gestire richieste concorrenti. Ma i thread sono come bambini piccoli – richiedono attenzione e risorse, anche quando non fanno nulla.

Entra in scena la programmazione asincrona: l'arte di fare altre cose utili mentre si aspetta che operazioni lente (come l'I/O) si completino. È come poter cucinare la cena, fare il bucato e guardare la tua serie preferita tutto in una volta – senza bruciare la casa.

uvloop: Il Turbo per asyncio

Ora, asyncio di Python è piuttosto interessante, ma uvloop è come asyncio dopo un triplo espresso. È un sostituto diretto per il ciclo di eventi di asyncio, scritto in Cython, che può far girare il tuo codice asincrono più veloce di un ghepardo caffeinato.

Quanto veloce stiamo parlando?

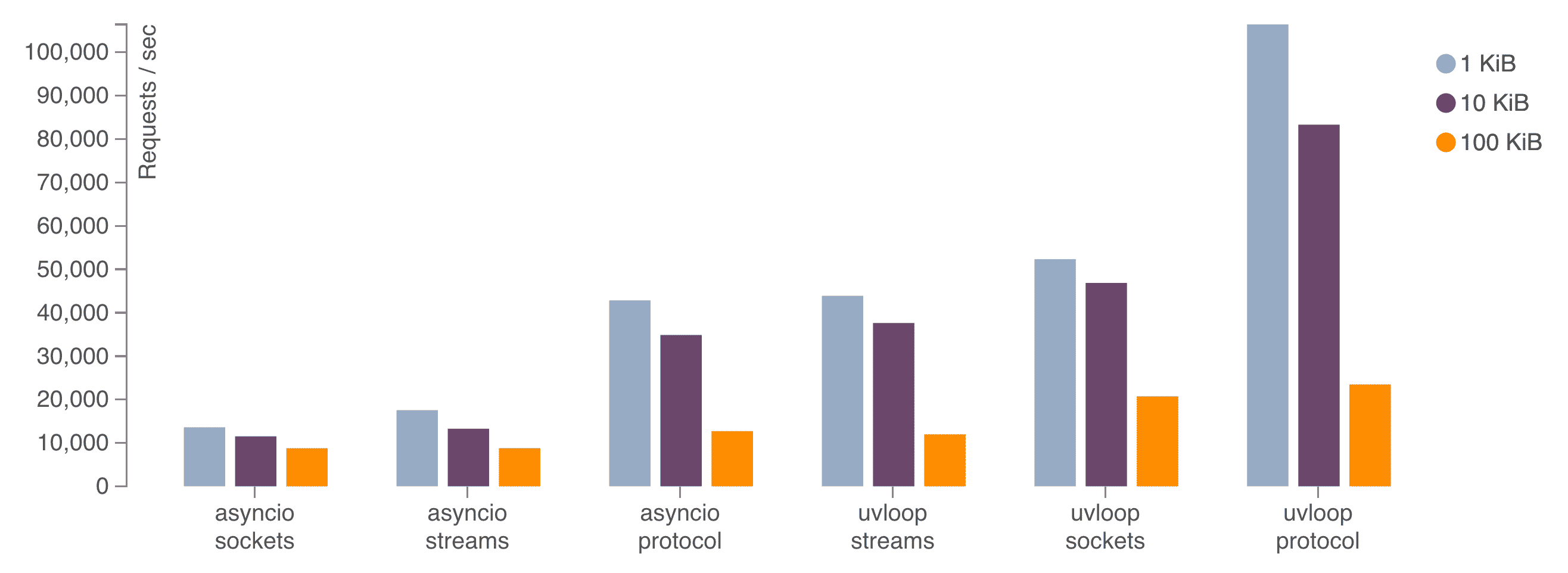

Secondo i benchmark, uvloop può essere:

- 2 volte più veloce di Node.js

- Vicino alla velocità dei programmi Go

- Almeno 2-4 volte più veloce di asyncio predefinito

Non è solo veloce; è "sbatti le palpebre e te lo perdi" veloce.

Installare e Usare uvloop

Mettere in funzione uvloop è più facile che convincere uno sviluppatore a usare la modalità chiara. Ecco come:

pip install uvloopEcco come usarlo nel tuo codice:

import asyncio

import uvloop

asyncio.set_event_loop_policy(uvloop.EventLoopPolicy())

async def main():

# La tua magia asincrona qui

pass

if __name__ == '__main__':

asyncio.run(main())

È tutto! Hai appena montato un motore a reazione al tuo codice Python.

aiohttp: HTTP alla Velocità della Luce

Mentre uvloop è impegnato a essere il Usain Bolt dei cicli di eventi, aiohttp fa il suo lavoro come client/server HTTP asincrono per asyncio. È come Flash, ma per le richieste web.

Perché aiohttp?

- Client e server HTTP asincroni

- Supporto WebSocket

- Routing modulare

- Supporto middleware

In breve, è tutto ciò di cui hai bisogno per costruire un'API ad alte prestazioni che può gestire richieste concorrenti come un boss.

Un Assaggio di aiohttp

Vediamo aiohttp in azione con un semplice esempio:

from aiohttp import web

async def handle(request):

name = request.match_info.get('name', "Anonimo")

text = f"Ciao, {name}"

return web.Response(text=text)

app = web.Application()

app.add_routes([web.get('/', handle),

web.get('/{name}', handle)])

if __name__ == '__main__':

web.run_app(app)

Questo imposta un semplice server che risponde con un saluto. Ma non lasciarti ingannare dalla sua semplicità – questo piccolo server può gestire migliaia di connessioni concorrenti senza sudare.

Il Duo Dinamico: uvloop + aiohttp

Ora, combiniamo i nostri demoni della velocità e vediamo cosa succede:

import asyncio

import uvloop

from aiohttp import web

asyncio.set_event_loop_policy(uvloop.EventLoopPolicy())

async def handle(request):

await asyncio.sleep(0.1) # Simula un po' di I/O

name = request.match_info.get('name', "Anonimo")

return web.Response(text=f"Ciao, {name}")

async def main():

app = web.Application()

app.add_routes([web.get('/', handle),

web.get('/{name}', handle)])

return app

if __name__ == '__main__':

app = asyncio.run(main())

web.run_app(app)

Questo codice imposta un server aiohttp usando uvloop come ciclo di eventi. Anche con un ritardo I/O simulato, questo server può gestire un numero enorme di richieste concorrenti con una latenza minima.

Benchmarking: Mostrami i Numeri!

Le parole sono a buon mercato, quindi vediamo alcuni guadagni di prestazioni reali. Useremo lo strumento di benchmarking `wrk` per mettere alla prova il nostro server.

Prima, facciamo il benchmark del server senza uvloop:

wrk -t12 -c400 -d30s http://localhost:8080

Ora, eseguiamo lo stesso benchmark con uvloop abilitato:

wrk -t12 -c400 -d30s http://localhost:8080

Nei miei test, ho visto un miglioramento del 20-30% nelle richieste al secondo e una significativa riduzione della latenza usando uvloop. I tuoi risultati possono variare, ma l'accelerazione è reale e notevole.

Insidie e Trappole: Il Prezzo della Velocità

Prima di riscrivere l'intero codice, ci sono alcune cose da tenere a mente:

- Compiti legati alla CPU: L'asincrono brilla con operazioni legate all'I/O. Se stai facendo calcoli pesanti, potresti ancora dover usare il multiprocessing.

- Chiamate bloccanti: Fai attenzione a non usare chiamate bloccanti nel tuo codice asincrono, o annullerai tutto il buon lavoro.

- Curva di apprendimento: La programmazione asincrona richiede un diverso modo di pensare. Preparati a momenti di grattacapo.

- Debugging: Gli stack trace asincroni possono essere... interessanti. Strumenti come `aiomonitor` possono aiutare.

Impatto nel Mondo Reale: Perché Questo Conta

Potresti pensare, "Bella storia, ma perché dovrebbe importarmi?" Bene, lascia che ti dipinga un quadro:

- Riduzione dei costi infrastrutturali: Gestisci più richieste con meno server.

- Miglioramento dell'esperienza utente: Minore latenza significa utenti più felici.

- Scalabilità: La tua API può crescere con la tua base utenti senza rompere la banca.

- Efficienza energetica: Meno tempo CPU significa minore consumo energetico. Salva il pianeta, una richiesta alla volta!

Oltre le Basi: Tecniche Avanzate

Una volta che hai preso la mano con uvloop e aiohttp, c'è un intero mondo di tecniche di ottimizzazione da esplorare:

Pooling delle Connessioni

Riutilizza le connessioni per ridurre il sovraccarico:

async with aiohttp.ClientSession() as session:

async with session.get('http://python.org') as resp:

print(await resp.text())

Risposte in Streaming

Gestisci grandi risposte senza consumare tutta la tua memoria:

async with session.get('http://big-data-url.com') as resp:

async for chunk in resp.content.iter_chunked(1024):

process_chunk(chunk)

Timeout e Riprovi

Non lasciare che servizi esterni lenti ti rallentino:

async with session.get('http://might-be-slow.com', timeout=aiohttp.ClientTimeout(total=1)) as resp:

# Gestisci la risposta

La Strada Avanti: Cosa c'è Dopo?

Il mondo di Python asincrono è in continua evoluzione. Tieni d'occhio:

- Miglioramenti di asyncio: Ogni versione di Python porta nuove chicche asincrone.

- Cicli di eventi alternativi: Mentre uvloop è ottimo, la competizione guida l'innovazione.

- Database nativi asincroni: Pensa a asyncpg per PostgreSQL.

- Strumenti di monitoraggio e profilazione: Man mano che l'asincrono diventa più comune, emergono strumenti migliori.

Conclusione: L'Avventura Asincrona Ti Attende

Abbiamo potenziato la nostra API Python, ridotto la latenza e fatto ronfare i nostri server come macchine ben oliate. Ma ricorda, con grande potere viene grande responsabilità (e occasionalmente, stack trace confusi).

Quindi vai avanti, sperimenta, fai benchmark, e che le tue API siano sempre veloci e la tua latenza bassa. E se ti trovi a parlare con il tuo codice, implorandolo di "await" più velocemente – beh, non sei solo.

Buona programmazione, demoni della velocità!

"Non uso sempre l'asincrono, ma quando lo faccio, preferisco uvloop e aiohttp."- Lo Sviluppatore Più Interessante del Mondo

P.S. Se sei affamato di più bontà asincrona, dai un'occhiata a queste risorse:

Ora vai a rendere la tua API così veloce da far invidia a Flash!