I soliti sospetti

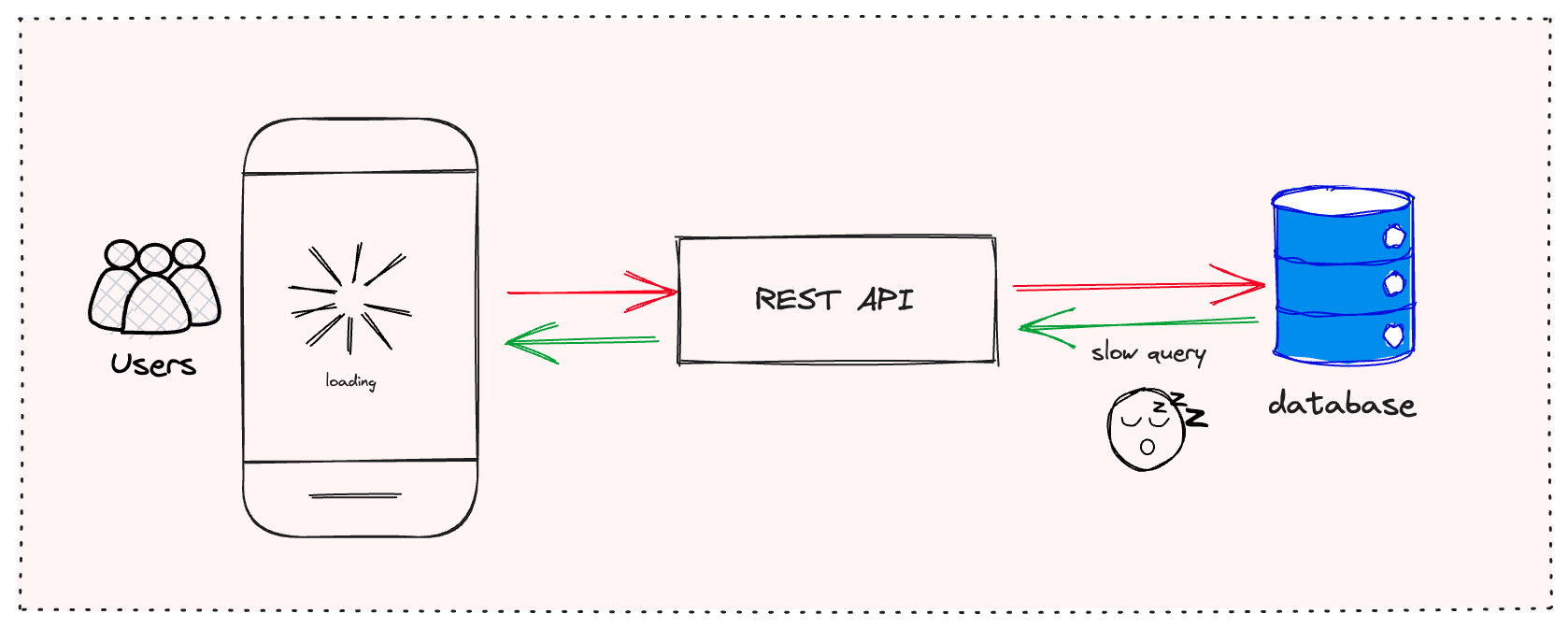

Prima di affrontare i colpevoli più subdoli, passiamo rapidamente in rassegna i soliti sospetti che probabilmente hai già considerato:

- Query inefficienti al database

- Mancanza di caching

- Configurazioni del server non ottimizzate

- Latenza di rete

Se hai già affrontato questi problemi e continui a riscontrare prestazioni scadenti, è il momento di guardare più a fondo. Smascheriamo i villain nascosti che si annidano nell'ombra della tua API.

1. Il rallentamento della serializzazione

Ah, la serializzazione. L'eroe (o il villain) non celebrato delle prestazioni delle API. Potresti non pensarci due volte, ma convertire i tuoi oggetti in JSON e viceversa può essere un collo di bottiglia significativo, specialmente con payload di grandi dimensioni.

Il problema:

Molte librerie di serializzazione popolari, sebbene convenienti, non sono ottimizzate per la velocità. Spesso utilizzano la riflessione, che può essere lenta, specialmente in linguaggi come Java.

La soluzione:

Considera l'uso di librerie di serializzazione più veloci. Per Java, ad esempio, Jackson con il modulo afterburner o DSL-JSON possono accelerare significativamente le cose. Ecco un esempio rapido usando l'afterburner di Jackson:

ObjectMapper mapper = new ObjectMapper();

mapper.registerModule(new AfterburnerModule());

// Ora usa questo mapper per la serializzazione/deserializzazione

String json = mapper.writeValueAsString(myObject);

MyObject obj = mapper.readValue(json, MyObject.class);

Ricorda, ogni millisecondo conta quando gestisci migliaia di richieste!

2. Il validatore troppo zelante

La validazione degli input è cruciale, ma stai esagerando? Una validazione eccessivamente complessa può trasformarsi in un incubo di prestazioni più velocemente di quanto tu possa dire "400 Bad Request".

Il problema:

Validare ogni singolo campo con regole complesse, specialmente per oggetti di grandi dimensioni, può rallentare significativamente la tua API. Inoltre, se stai usando un framework di validazione pesante, potresti incorrere in un sovraccarico non necessario.

La soluzione:

Trova un equilibrio. Valida i campi critici lato server, ma considera di delegare parte della validazione al client. Usa librerie di validazione leggere e considera di memorizzare nella cache i risultati della validazione per i dati a cui si accede frequentemente.

Ad esempio, se stai usando la Bean Validation di Java, puoi memorizzare nella cache l'istanza del Validator:

private static final Validator validator;

static {

ValidatorFactory factory = Validation.buildDefaultValidatorFactory();

validator = factory.getValidator();

}

// Usa questa istanza di validator in tutta la tua applicazione

3. La valanga di autenticazione

La sicurezza è imprescindibile, ma un'autenticazione mal implementata può trasformare la tua API in un disastro lento.

Il problema:

Autenticare ogni richiesta colpendo il database o un servizio di autenticazione esterno può introdurre una latenza significativa, specialmente sotto carico elevato.

La soluzione:

Implementa l'autenticazione basata su token con caching. I JSON Web Tokens (JWT) sono un'ottima opzione. Ti permettono di verificare la firma del token senza colpire il database ad ogni richiesta.

Ecco un semplice esempio usando la libreria jjwt in Java:

String jwtToken = Jwts.builder()

.setSubject(username)

.signWith(SignatureAlgorithm.HS256, secretKey)

.compact();

// Successivamente, per verificare:

Jws claims = Jwts.parser()

.setSigningKey(secretKey)

.parseClaimsJws(jwtToken);

String username = claims.getBody().getSubject();

4. La sindrome dell'API loquace

La tua API è più loquace di un conduttore di podcast? Richieste HTTP eccessive possono essere un grande killer delle prestazioni.

Il problema:

Le API che richiedono più viaggi di andata e ritorno per completare una singola operazione logica possono soffrire di latenza aumentata e throughput ridotto.

La soluzione:

Abbraccia il batching e le operazioni in blocco. Invece di fare chiamate separate per ogni elemento, consenti ai client di inviare più elementi in una singola richiesta. GraphQL può anche essere un punto di svolta qui, permettendo ai client di richiedere esattamente ciò di cui hanno bisogno in una singola query.

Se stai usando Spring Boot, puoi facilmente implementare un endpoint batch:

@PostMapping("/users/batch")

public List createUsers(@RequestBody List users) {

return userService.createUsers(users);

}

5. Il blob di risposta gonfio

Le risposte della tua API trasportano più peso di un lottatore di sumo? Risposte eccessivamente verbose possono rallentare la tua API e aumentare l'uso della larghezza di banda.

Il problema:

Restituire più dati del necessario, inclusi campi che non sono utilizzati dal client, può aumentare significativamente la dimensione della risposta e il tempo di elaborazione.

La soluzione:

Implementa il filtraggio delle risposte e la paginazione. Consenti ai client di specificare quali campi vogliono che vengano restituiti. Per le collezioni, usa sempre la paginazione per limitare la quantità di dati inviati in una singola risposta.

Ecco un esempio di come potresti implementare il filtraggio dei campi in Spring Boot:

@GetMapping("/users")

public List getUsers(@RequestParam(required = false) String fields) {

List users = userService.getAllUsers();

if (fields != null) {

ObjectMapper mapper = new ObjectMapper();

SimpleFilterProvider filterProvider = new SimpleFilterProvider();

filterProvider.addFilter("userFilter", SimpleBeanPropertyFilter.filterOutAllExcept(fields.split(",")));

mapper.setFilterProvider(filterProvider);

return mapper.convertValue(users, new TypeReference>() {});

}

return users;

}

6. Il lamento del caricatore impaziente

Stai recuperando dati come se ti stessi preparando per un'apocalisse di dati? Un caricamento eccessivo dei dati può essere un killer silenzioso delle prestazioni.

Il problema:

Caricare tutte le entità correlate per un oggetto, anche quando non sono necessarie, può comportare query al database non necessarie e tempi di risposta aumentati.

La soluzione:

Implementa il caricamento lazy e usa le proiezioni. Recupera solo i dati di cui hai bisogno quando ne hai bisogno. Molti ORM supportano il caricamento lazy di default, ma devi usarlo saggiamente.

Se stai usando Spring Data JPA, puoi creare proiezioni per recuperare solo i campi richiesti:

public interface UserSummary {

Long getId();

String getName();

String getEmail();

}

@Repository

public interface UserRepository extends JpaRepository {

List findAllProjectedBy();

}

7. La strategia di caching inconsapevole

Hai implementato il caching, datti una pacca sulla spalla! Ma aspetta, stai facendo caching in modo intelligente o stai semplicemente memorizzando tutto ciò che vedi?

Il problema:

Il caching senza una strategia adeguata può portare a dati obsoleti, uso inutile della memoria e persino prestazioni più lente se non fatto correttamente.

La soluzione:

Implementa una strategia di caching intelligente. Memorizza nella cache i dati a cui si accede frequentemente e che cambiano raramente. Usa politiche di eliminazione della cache e considera l'uso di una cache distribuita per la scalabilità.

Ecco un esempio usando l'astrazione di caching di Spring:

@Cacheable(value = "users", key = "#id", unless = "#result == null")

public User getUserById(Long id) {

return userRepository.findById(id).orElse(null);

}

@CacheEvict(value = "users", key = "#user.id")

public void updateUser(User user) {

userRepository.save(user);

}

Conclusioni

L'ottimizzazione delle prestazioni è un processo continuo, non un compito una tantum. Questi killer nascosti possono insinuarsi nella tua API nel tempo, quindi è cruciale profilare e monitorare regolarmente le prestazioni della tua API.

Ricorda, il codice più veloce è spesso quello che non viene eseguito affatto. Chiediti sempre se è necessario eseguire un'operazione, recuperare un dato o includere un campo nella tua risposta.

Affrontando questi killer delle prestazioni nascosti, puoi trasformare la tua API lenta in una macchina snella ed efficiente nella gestione delle richieste. I tuoi utenti (e il tuo team operativo) te ne saranno grati!

"L'ottimizzazione prematura è la radice di tutti i mali." - Donald Knuth

Ma quando si tratta di API, l'ottimizzazione tempestiva è la chiave del successo. Quindi vai avanti, profila la tua API e che i tuoi tempi di risposta siano sempre a tuo favore!

Spunti di riflessione

Prima di precipitarti a ottimizzare la tua API, prenditi un momento per riflettere:

- Stai misurando i giusti parametri? Il tempo di risposta è importante, ma considera anche il throughput, i tassi di errore e l'utilizzo delle risorse.

- Hai considerato i compromessi? A volte, ottimizzare per la velocità potrebbe andare a scapito della leggibilità o della manutenibilità. Ne vale la pena?

- Stai ottimizzando per i giusti casi d'uso? Assicurati di concentrarti sugli endpoint e le operazioni che contano di più per i tuoi utenti.

Ricorda, l'obiettivo non è solo avere un'API veloce, ma avere un'API che fornisca valore ai tuoi utenti in modo efficiente e affidabile. Ora vai a far volare la tua API!