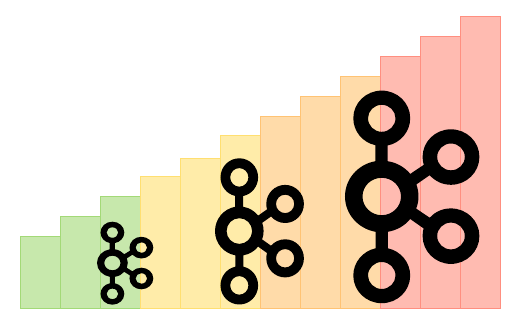

La scalabilità orizzontale ci permette di:

- Gestire enormi flussi di dati senza sudare

- Distribuire il carico di elaborazione su più nodi

- Migliorare la tolleranza ai guasti (perché chi non ama un buon failover?)

- Mantenere una bassa latenza anche quando i volumi di dati esplodono

Ma ecco il punto: scalare Kafka Streams orizzontalmente non è così semplice come avviare più istanze e chiamarla una giornata. Oh no, amici miei. È più come aprire il vaso di Pandora delle sfide dei sistemi distribuiti.

L'Anatomia della Scalabilità di Kafka Streams

Prima di immergerci nei problemi, diamo un'occhiata veloce a come Kafka Streams effettivamente scala. Non è magia (purtroppo), ma è piuttosto ingegnoso:

- Kafka Streams divide la tua topologia in task

- Ogni task elabora una o più partizioni dei tuoi topic di input

- Quando aggiungi più istanze, Kafka Streams ridistribuisce questi task

Sembra semplice, vero? Bene, tieniti forte, perché è qui che le cose iniziano a diventare interessanti (e per interessanti, intendo potenzialmente frustranti).

La Lotta con lo Stato

Una delle sfide più grandi nello scalare Kafka Streams deriva dalla gestione delle operazioni con stato. Sai, quelle aggregazioni e join fastidiosi che rendono la nostra vita sia più facile che più difficile allo stesso tempo.

Il problema? Lo stato. È ovunque e non ama muoversi.

"Lo stato è come quell'amico che rimane sempre troppo a lungo alle feste. È utile averlo intorno, ma rende l'andarsene (o nel nostro caso, scalare) un vero dolore."

Quando si scala, Kafka Streams deve spostare lo stato. Questo porta a situazioni complicate:

- Calate temporanee delle prestazioni durante la migrazione dello stato

- Potenziali incoerenze nei dati se non gestite correttamente

- Aumento del traffico di rete mentre lo stato viene riorganizzato

Per mitigare questi problemi, dovrai prestare molta attenzione alla configurazione di RocksDB. Ecco un esempio per iniziare:

Properties props = new Properties();

props.put(StreamsConfig.ROCKSDB_CONFIG_SETTER_CLASS_CONFIG, CustomRocksDBConfig.class);

E nella tua classe CustomRocksDBConfig:

public class CustomRocksDBConfig implements RocksDBConfigSetter {

@Override

public void setConfig(final String storeName, final Options options, final Map configs) {

BlockBasedTableConfig tableConfig = new BlockBasedTableConfig();

tableConfig.setBlockCacheSize(50 * 1024 * 1024L);

tableConfig.setBlockSize(4096L);

options.setTableFormatConfig(tableConfig);

options.setMaxWriteBufferNumber(3);

}

}

Questa configurazione può aiutare a ridurre l'impatto della migrazione dello stato ottimizzando come RocksDB gestisce i dati. Ma ricorda, non esiste una soluzione unica per tutti. Dovrai adattare in base al tuo caso d'uso specifico.

L'Atto del Ribilanciamento

Aggiungere nuove istanze alla tua applicazione Kafka Streams innesca un ribilanciamento. In teoria, è fantastico – è così che distribuiamo il carico. In pratica, è come cercare di riorganizzare il tuo armadio mentre ti vesti per una festa.

Durante un ribilanciamento:

- L'elaborazione si ferma (speriamo che non ti servissero quei dati subito!)

- Lo stato deve essere migrato (vedi il nostro punto precedente sulle lotte con lo stato)

- Il tuo sistema potrebbe sperimentare una latenza temporaneamente più alta

Per minimizzare il dolore del ribilanciamento, considera quanto segue:

- Usa il partizionamento sticky per ridurre i movimenti di partizione non necessari

- Implementa un assegnatore di partizioni personalizzato per avere più controllo

- Regola il tuo

max.poll.interval.msper consentire tempi di elaborazione più lunghi durante i ribilanciamenti

Ecco come potresti configurare il partizionamento sticky nella tua applicazione Quarkus:

quarkus.kafka-streams.partition.assignment.strategy=org.apache.kafka.streams.processor.internals.StreamsPartitionAssignor

Il Paradosso delle Prestazioni

Ecco un fatto divertente: a volte aggiungere più istanze può effettivamente ridurre le tue prestazioni complessive. Lo so, sembra una brutta battuta, ma è fin troppo reale.

I colpevoli?

- Aumento del traffico di rete

- Ribilanciamenti più frequenti

- Maggiore overhead di coordinamento

Per combattere questo, devi essere strategico su come scalare. Alcuni consigli:

- Monitora attentamente il tuo throughput e la latenza

- Scala in incrementi più piccoli

- Ottimizza la tua strategia di partizionamento dei topic

Parlando di monitoraggio, ecco un esempio rapido di come potresti impostare alcune metriche di base nella tua applicazione Quarkus:

@Produces

@ApplicationScoped

public KafkaStreams kafkaStreams(KafkaStreamsBuilder builder) {

Properties props = new Properties();

props.put(StreamsConfig.METRICS_RECORDING_LEVEL_CONFIG, Sensor.RecordingLevel.DEBUG.name());

return builder.withProperties(props).build();

}

Questo ti darà metriche più dettagliate con cui lavorare, aiutandoti a identificare i colli di bottiglia delle prestazioni mentre scali.

Il Dilemma della Consistenza dei Dati

Man mano che si scala, mantenere la consistenza dei dati diventa più complicato. Ricorda, Kafka Streams garantisce l'ordine di elaborazione all'interno di una partizione, ma quando stai gestendo più istanze e ribilanciamenti, le cose possono diventare disordinate.

Le sfide principali includono:

- Garantire la semantica esattamente una volta tra le istanze

- Gestire eventi fuori ordine durante i ribilanciamenti

- Gestire le finestre temporali tra store di stato distribuiti

Per affrontare questi problemi:

- Usa la garanzia di elaborazione esattamente una volta (ma sii consapevole del compromesso sulle prestazioni)

- Implementa una gestione degli errori e meccanismi di retry adeguati

- Considera l'uso di un

TimestampExtractorpersonalizzato per un migliore controllo sul tempo degli eventi

Ecco come potresti configurare la semantica esattamente una volta nella tua applicazione Quarkus:

quarkus.kafka-streams.processing.guarantee=exactly_once

Ma ricorda, con grande potere viene grande responsabilità (e potenzialmente maggiore latenza).

Il Mal di Testa della Gestione degli Errori

Quando si tratta di sistemi distribuiti, gli errori non sono solo possibili – sono inevitabili. E in un'applicazione Kafka Streams scalata, la gestione degli errori diventa ancora più critica.

Scenari comuni di errore includono:

- Partizioni di rete che causano la desincronizzazione delle istanze

- Errori di deserializzazione dovuti a cambiamenti di schema

- Eccezioni di elaborazione che potrebbero potenzialmente avvelenare l'intero stream

Per costruire un sistema più resiliente:

- Implementa una gestione degli errori robusta nei tuoi processori di stream

- Usa le Dead Letter Queue (DLQ) per i messaggi che falliscono l'elaborazione

- Imposta un monitoraggio e un allarme adeguati per una rapida rilevazione dei problemi

Ecco un semplice esempio di come potresti implementare una DLQ nella tua topologia Kafka Streams:

builder.stream("input-topic")

.mapValues((key, value) -> {

try {

return processValue(value);

} catch (Exception e) {

// Invia alla DLQ

producer.send(new ProducerRecord<>("dlq-topic", key, value));

return null;

}

})

.filter((key, value) -> value != null)

.to("output-topic");

In questo modo, tutti i messaggi che falliscono l'elaborazione vengono inviati a una DLQ per un'ispezione successiva e un potenziale rielaborazione.

Le Peculiarità di Quarkus

Ora, potresti pensare, "Ok, ma come si inserisce Quarkus in tutto questo?" Bene, amico mio, Quarkus porta il suo sapore alla festa della scalabilità di Kafka Streams.

Alcune considerazioni specifiche di Quarkus:

- Sfruttare i tempi di avvio rapidi di Quarkus per una scalabilità più veloce

- Utilizzare le opzioni di configurazione di Quarkus per ottimizzare Kafka Streams

- Sfruttare la compilazione nativa di Quarkus per migliorare le prestazioni

Ecco un trucco interessante: puoi usare le proprietà di configurazione di Quarkus per regolare dinamicamente la configurazione di Kafka Streams in base all'ambiente. Ad esempio:

%dev.quarkus.kafka-streams.bootstrap-servers=localhost:9092

%prod.quarkus.kafka-streams.bootstrap-servers=${KAFKA_BOOTSTRAP_SERVERS}

quarkus.kafka-streams.application-id=${KAFKA_APPLICATION_ID:my-streams-app}

Questo ti permette di passare facilmente tra configurazioni di sviluppo e produzione, rendendo la tua vita un po' più facile mentre scali.

Conclusione: La Saga della Scalabilità Continua

Scalare orizzontalmente Kafka Streams in Quarkus non è una passeggiata nel parco. È più come un'escursione attraverso una giungla densa piena di sabbie mobili con stato, viti di ribilanciamento e predatori che mangiano prestazioni. Ma armato della giusta conoscenza e degli strumenti, puoi navigare in questo terreno e costruire applicazioni di elaborazione di stream veramente scalabili e resilienti.

Ricorda:

- Monitora, monitora, monitora – non puoi risolvere ciò che non puoi vedere

- Testa a fondo le tue strategie di scalabilità prima di andare in produzione

- Sii pronto a iterare e ottimizzare la tua configurazione

- Abbraccia le sfide – sono ciò che ci rende migliori ingegneri (o almeno così continuo a dirmi)

Man mano che intraprendi il tuo viaggio di scalabilità di Kafka Streams, tieni questa guida a portata di mano. E ricorda, quando sei in dubbio, aggiungi più istanze! (Scherzo, per favore non farlo senza una pianificazione adeguata.)

Buon streaming, e che le tue partizioni siano sempre perfettamente bilanciate!