Supponiamo di eseguire un'applicazione Flask su Gunicorn (perché siamo fighi così). Abbiamo alcuni endpoint, e uno di loro sta dando problemi. È ora di indossare i nostri occhiali py-spy e vedere cosa succede.

Il nostro sospetto: il gestore affamato di CPU

Ecco una semplice app Flask con un gestore che chiaramente non si comporta bene:

from flask import Flask

import time

app = Flask(__name__)

@app.route('/')

def hello_world():

return 'Hello, World!'

@app.route('/cpu_hog')

def cpu_hog():

# Qui avviene la magia (leggi: problema)

result = 0

for i in range(10000000):

result += i

return f"Ho contato fino a {result}. Non sei orgoglioso?"

if __name__ == '__main__':

app.run()

Avviso spoiler: quell'endpoint /cpu_hog è il nostro principale sospettato.

Entra in scena py-spy: il nostro aiutante per il profiling

Prima di tutto, mettiamo py-spy nella nostra squadra:

pip install py-spy

Ora, avviamo il nostro server Gunicorn:

gunicorn app:app -w 4

Ecco la parte divertente. In un altro terminale, scatenamo py-spy sul nostro server WSGI ignaro:

sudo py-spy record -o profile.svg --pid $(pgrep -f gunicorn) --subprocesses

Consiglio Pro: Stiamo usando sudo qui perché py-spy deve collegarsi al processo. Fai attenzione con i poteri di sudo, però. Con grandi poteri viene... beh, sai il resto.Decodifica dei risultati del profiling: CSI: edizione CPU

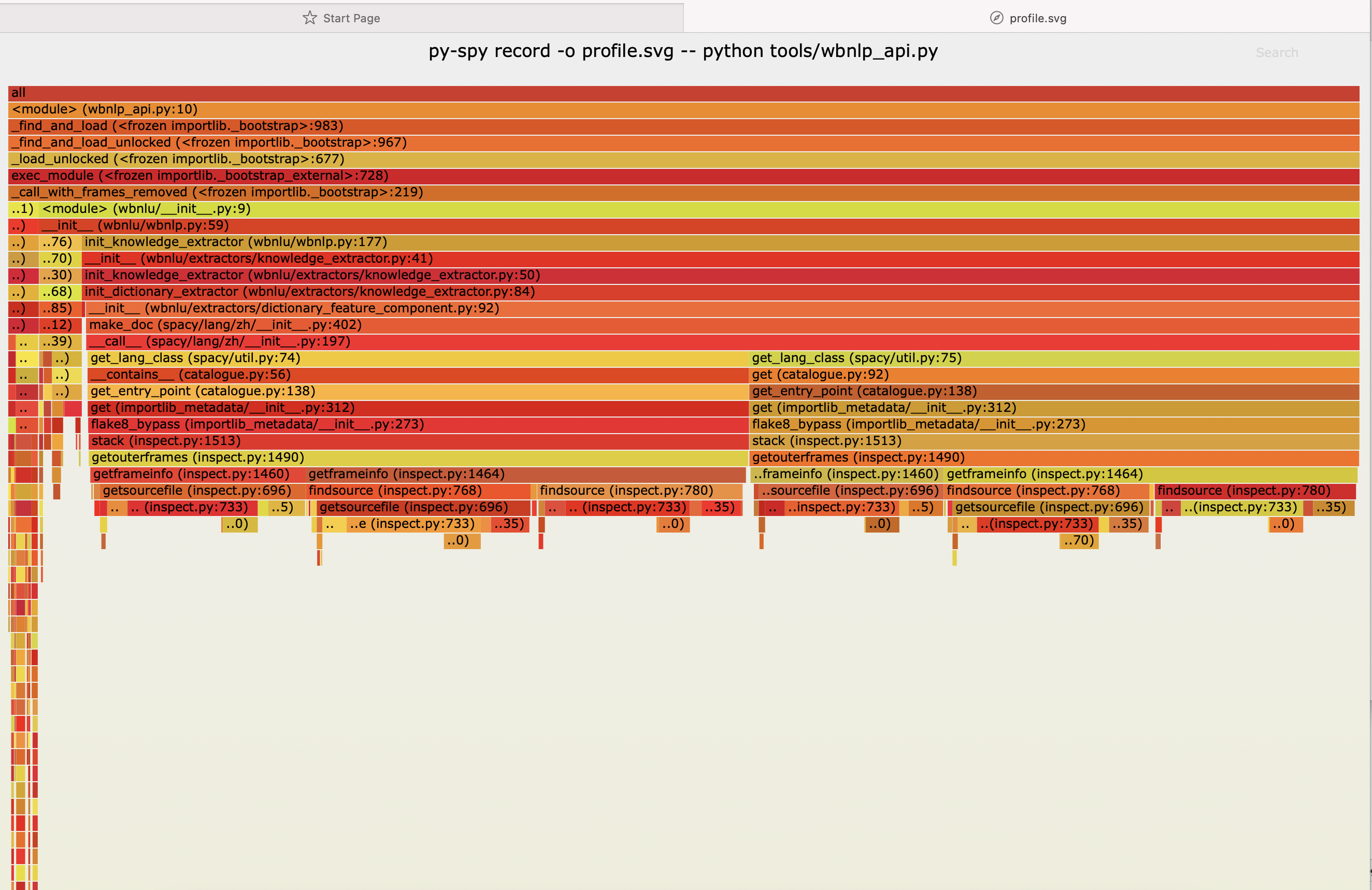

Dopo aver colpito il nostro endpoint /cpu_hog alcune volte (vai avanti, aspettiamo), diamo un'occhiata a quel bellissimo grafico a fiamma SVG che py-spy ha generato per noi.

Cosa vediamo? Un inferno di utilizzo della CPU nella nostra funzione cpu_hog! È come trovare Waldo, se Waldo fosse un collo di bottiglia delle prestazioni con una maglietta a righe di inefficienza.

Analisi del grafico a fiamma

- La larghezza di ogni barra rappresenta il tempo trascorso in quella funzione

- I colori? Sono solo belli. Non leggete troppo in essi.

- Le barre impilate mostrano lo stack delle chiamate. È come un sandwich di lentezza.

La trama si infittisce: analisi delle nostre scoperte

Quindi, cosa abbiamo imparato dalla nostra avventura con py-spy?

- La nostra funzione

cpu_hogsta facendo onore al suo nome. Sta monopolizzando la CPU come se non ci fosse un domani. - Il colpevole? Quel ciclo

fordall'aspetto innocente. Sta facendo più iterazioni di una lavatrice bloccata sul ciclo di centrifuga. - I nostri altri endpoint (come

hello_world) sono appena visibili. Sono gli eroi non celebrati della nostra app.

Colpo di scena: ottimizzazione del nostro CPU Hog

Ora che abbiamo colto il nostro colpevole delle prestazioni con le mani nel sacco, riformiamolo:

@app.route('/cpu_hog_reformed')

def cpu_hog_reformed():

# Usiamo un modo più efficiente per sommare i numeri

result = sum(range(10000001))

return f"Ho contato efficientemente fino a {result}. Molto meglio, vero?"

Esegui di nuovo py-spy con questo nuovo endpoint, e voilà! Il nostro grafico a fiamma dovrebbe sembrare meno un inferno e più un accogliente falò.

Lezioni apprese: il manuale del profiling con py-spy

Quali perle di saggezza possiamo trarre da questa avventura di profiling?

- Fidati, ma verifica: Anche il codice che sembra semplice può essere un incubo di prestazioni. Profilare sempre prima di ottimizzare.

- py-spy è tuo amico: È non intrusivo, veloce e ti offre una rappresentazione visiva del tuo utilizzo della CPU. Cosa non amare?

- Pensa in modo algoritmico: A volte, la migliore ottimizzazione è usare un algoritmo più efficiente. La notazione Big O non è solo per i colloqui su lavagna!

- I server WSGI sono bestie complesse: Ricorda, non stiamo solo profilando la nostra app, ma l'intero ecosistema WSGI. È tartarughe fino in fondo!

L'epilogo: mantieni la calma e continua a profilare

Profilare con py-spy è come fare un check-up alla salute del tuo codice. Potrebbe rivelare alcune verità scomode, ma alla fine, la tua applicazione ti ringrazierà. E ricorda, ogni millisecondo conta quando stai servendo richieste web!

Quindi, la prossima volta che il tuo server WSGI Python inizia a comportarsi male, non farti prendere dal panico. Prendi py-spy, genera quei grafici a fiamma e inizia a cacciare quei CPU hog. I tuoi utenti (e il tuo capo) ti ringrazieranno.

Spunto di riflessione: Quali altre parti della tua applicazione potrebbero beneficiare di una sessione di profiling con py-spy? Query al database? Chiamate API esterne? Le possibilità sono infinite!

Ora vai avanti e profila, tu magnifico detective del codice!