TL;DR: Cosa c'è di nuovo nel Cooperative Scheduling di Rust 1.80?

- Migliorati i meccanismi di cessione dei task

- Migliore integrazione con runtime asincroni come Tokio

- Maggiore equità nell'esecuzione dei task

- Nuove API per un controllo più dettagliato sulla pianificazione dei task

Il Dilemma del Cooperative Scheduling

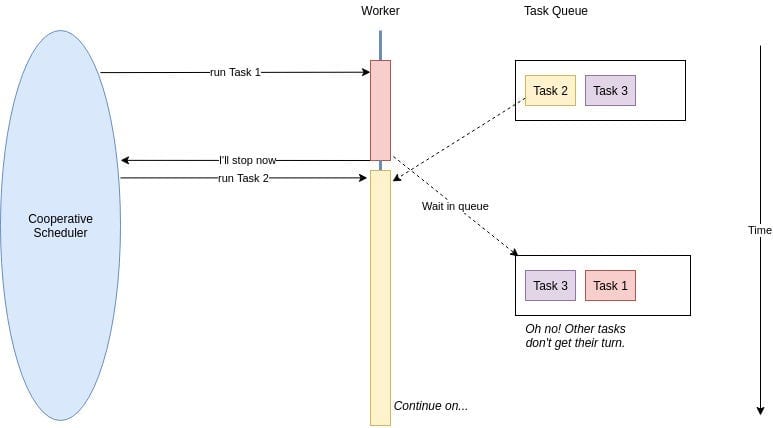

Prima di addentrarci nei dettagli, rinfreschiamo la memoria su cosa sia il cooperative scheduling. Nel mondo asincrono di Rust, i task collaborano cedendo volontariamente il controllo, permettendo ad altri task di eseguire. È come una fila di persone educate, dove tutti lasciano passare gli altri se non sono ancora pronti.

Tuttavia, nelle versioni precedenti di Rust, questa cortesia a volte portava a situazioni imbarazzanti. Task di lunga durata potevano monopolizzare l'attenzione, lasciando altre operazioni critiche in attesa. Entra in scena Rust 1.80, con una serie di miglioramenti per rendere questa danza più armoniosa.

I Nuovi Arrivati: Meccanismi di Cessione Migliorati

Rust 1.80 introduce meccanismi di cessione più sofisticati che permettono ai task di essere vicini più rispettosi. Ecco un rapido sguardo su come utilizzare queste nuove funzionalità:

use std::future::Future;

use std::pin::Pin;

use std::task::{Context, Poll};

struct YieldingTask {

yielded: bool,

}

impl Future for YieldingTask {

type Output = ();

fn poll(mut self: Pin<&mut Self>, cx: &mut Context<'_>) -> Poll {

if !self.yielded {

self.yielded = true;

cx.waker().wake_by_ref();

Poll::Pending

} else {

Poll::Ready(())

}

}

}

Questo esempio mostra un task che cede una volta prima di completare. Il nuovo metodo wake_by_ref() è più efficiente, evitando cloni non necessari del Waker.

Tokio e Rust 1.80: Un'Accoppiata Perfetta nel Mondo Asincrono

Se stai usando Tokio (e diciamocelo, chi non lo fa?), sei in una botte di ferro. I miglioramenti di Rust 1.80 si integrano perfettamente con il runtime di Tokio. Ecco come puoi sfruttare questa sinergia:

use tokio::time::{sleep, Duration};

#[tokio::main]

async fn main() {

let task1 = tokio::spawn(async {

for i in 1..=5 {

println!("Task 1: {}", i);

sleep(Duration::from_millis(100)).await;

}

});

let task2 = tokio::spawn(async {

for i in 1..=5 {

println!("Task 2: {}", i);

sleep(Duration::from_millis(100)).await;

}

});

let _ = tokio::join!(task1, task2);

}

Questo esempio dimostra come il runtime di Tokio ora funzioni ancora meglio con il cooperative scheduling di Rust 1.80, garantendo un'esecuzione equa tra i task.

Equità: Non Solo per le Dispute nel Parco Giochi

Una delle caratteristiche distintive di Rust 1.80 è la maggiore equità nell'esecuzione dei task. Niente più task prepotenti che monopolizzano tutto il tempo della CPU! Il runtime ora distribuisce meglio le risorse tra i task, cruciale per i microservizi sotto carico pesante.

Considera questo scenario:

use tokio::time::{sleep, Duration};

use std::sync::Arc;

use std::sync::atomic::{AtomicUsize, Ordering};

#[tokio::main]

async fn main() {

let counter = Arc::new(AtomicUsize::new(0));

let tasks: Vec<_> = (0..100).map(|i| {

let counter = Arc::clone(&counter);

tokio::spawn(async move {

loop {

counter.fetch_add(1, Ordering::SeqCst);

if i % 10 == 0 {

sleep(Duration::from_millis(1)).await;

}

}

})

}).collect();

sleep(Duration::from_secs(5)).await;

for task in tasks {

task.abort();

}

println!("Incrementi totali: {}", counter.load(Ordering::SeqCst));

}

In questo esempio, creiamo 100 task, ognuno dei quali incrementa un contatore condiviso. Alcuni task (ogni decimo) dormono brevemente, simulando operazioni di I/O. Con la maggiore equità di Rust 1.80, noterai una distribuzione più bilanciata degli incrementi tra i task, anche sotto questo carico artificiale.

Controllo Dettagliato: Il Tuo Nuovo Superpotere

Rust 1.80 ti offre più controllo sulla pianificazione dei task con nuove API. È come avere una bacchetta magica per il tuo codice asincrono. Ecco un assaggio di ciò che puoi fare:

use std::future::Future;

use std::pin::Pin;

use std::task::{Context, Poll};

struct ControlledYield {

yields_left: usize,

}

impl Future for ControlledYield {

type Output = ();

fn poll(mut self: Pin<&mut Self>, cx: &mut Context<'_>) -> Poll {

if self.yields_left > 0 {

self.yields_left -= 1;

cx.waker().wake_by_ref();

Poll::Pending

} else {

Poll::Ready(())

}

}

}

async fn controlled_task(yields: usize) {

ControlledYield { yields_left: yields }.await;

println!("Task completato dopo {} cessioni", yields);

}

Questo future ControlledYield ti permette di specificare esattamente quante volte un task dovrebbe cedere prima di completare. È come avere un controllo preciso per il comportamento cooperativo di ogni task.

Le Insidie: Attento a Dove Metti i Piedi!

Sebbene i miglioramenti del cooperative scheduling di Rust 1.80 siano fantastici, non sono una soluzione universale. Ecco alcune insidie da evitare:

- Cedere troppo spesso può portare a cambi di contesto non necessari e ridurre le prestazioni.

- Cedere troppo poco nei task intensivi di CPU può ancora causare picchi di latenza.

- Affidarsi troppo all'equità del runtime può mascherare problemi di design sottostanti nella tua architettura di microservizi.

Mettere Tutto Insieme: Uno Scenario Reale

Vediamo un esempio più realistico di come questi miglioramenti possano essere applicati in un microservizio sotto carico pesante:

use tokio::time::{sleep, Duration};

use std::sync::Arc;

use tokio::sync::Semaphore;

async fn process_request(id: u32, semaphore: Arc) {

let _permit = semaphore.acquire().await.unwrap();

println!("Elaborazione richiesta {}", id);

// Simula un po' di lavoro

sleep(Duration::from_millis(100)).await;

println!("Richiesta completata {}", id);

}

#[tokio::main]

async fn main() {

let semaphore = Arc::new(Semaphore::new(10)); // Limita l'elaborazione concorrente

let mut handles = vec![];

for i in 0..1000 {

let sem = Arc::clone(&semaphore);

handles.push(tokio::spawn(async move {

process_request(i, sem).await;

}));

}

for handle in handles {

handle.await.unwrap();

}

}

In questo esempio, stiamo simulando un microservizio che elabora 1000 richieste contemporaneamente, ma limitando l'elaborazione effettiva concorrente a 10 alla volta usando un semaforo. Il migliorato cooperative scheduling di Rust 1.80 assicura che anche sotto questo carico pesante, ogni task abbia una giusta possibilità di esecuzione, impedendo a qualsiasi singola richiesta di monopolizzare le risorse.

Conclusione: Abbraccia lo Spirito Cooperativo

I miglioramenti di Rust 1.80 al cooperative scheduling sono una svolta per i microservizi che operano sotto carico pesante. Sfruttando questi miglioramenti, puoi:

- Ridurre i picchi di latenza garantendo un'esecuzione equa dei task

- Migliorare la reattività complessiva del sistema

- Ottimizzare il tuo codice asincrono per prestazioni ottimali

- Costruire microservizi più resilienti che possono gestire picchi di traffico con grazia

Ricorda, la chiave per padroneggiare queste nuove funzionalità è la pratica e la sperimentazione. Non aver paura di immergerti e vedere come possono trasformare la tua architettura di microservizi.

Spunti di Riflessione

"Nel mondo dei microservizi, la cooperazione non è solo un vantaggio, è essenziale per la sopravvivenza."

Mentre implementi questi nuovi schemi di cooperative scheduling, chiediti:

- Come posso identificare i colli di bottiglia nei miei attuali microservizi che potrebbero beneficiare di una pianificazione migliorata?

- Quali metriche dovrei monitorare per assicurarmi di ottenere il massimo da queste nuove funzionalità?

- Come posso educare il mio team su questi miglioramenti e incoraggiare le migliori pratiche nello sviluppo asincrono in Rust?

Ponendoti continuamente queste domande ed esplorando le capacità di Rust 1.80, sarai ben avviato a costruire microservizi che non solo sopravvivono sotto pressione, ma prosperano.

Ora vai avanti e collabora come mai prima d'ora! I tuoi microservizi (e i tuoi utenti) te ne saranno grati.